Ich bin zur Zeit viel mit meiner Infrarotkamera unterwegs. Ich war schon lange von diesem für unsere Augen eigentlich unsichtbaren Spektrum fasziniert und so kam es, dass ich 2019 meine damals etwas heruntergekämpfte Canon 20D konvertieren ließ. Einige Jahre später fotografiere ich meine IR-Aufnahmen immer noch im Canon-System, allerdings jetzt mit einer modifizierten EOS RP. Dank des Drop-in-Filter-Adapters kann ich so flexibel das gewünschte Lichtspektrum wählen und habe maximale Flexibilität in einer modernen Kamera und dank EF Bajonett einen gigantischen Objektivpark als Spielwiese.

Wer sich mit Infrarotfotografie befasst, wird schnell feststellen: Klassische Tools zur Bildbearbeitung kommen hier an ihre Grenzen. Speziell Lightroom, jahrelang mein Tool der Wahl, ist eigentlich so gar nicht auf IR ausgelegt. So legt einem LR schon beim ersten Entwicklungsschritt – der Wahl des richtigen Weißabgleichs – Steine in den Weg. Infrarotbilder sind ja sehr warm (rot eben) und um das auszugleichen, müssen wir den Weißabgleichsregler dramatisch nach links in den „kalten“ Bereich schieben. Lightroom hat da leider eine fest verdrahtete und „zu warme“ Untergrenze.

Findige Nutzer fanden dafür einen Workaround: Kameraprofile! Stellt sich nämlich raus, dass man in Lightroom kameraspezifische Profile erstellen und hinterlegen kann. An die zu kommen ist aber etwas fummelig, besonders wenn man die Lightroom-eigenen Begrenzungen umgehen muss. Die Lösung? Ein kostenloses DNG-Tool aus dem Jahr 2012 (!!) von Adobe, eigentlich gedacht für die Konvertierung von herstellereigenen RAW-Dateien zu DNG (mehr Info hier). In dem Tool öffnet man dann eine Beispieldatei, regelt unter „Color Matrices“ die Farbtemperatur maximal runter und exportiert den ganzen Bums dann als Kameraprofil. Das packt man dann in Lightroom als Datei ins dafür vorgesehene Profilverzeichnis und wählt es entweder danach ggf. manuell aus oder konfiguriert es als Standard für den Fall, dass genau diese Kamera als Urheber in den Raw-Dateien steht. Soweit so umständlich (Hier ist eine Anleitung), aber wenigstens kann man jetzt auch für solche Dateien den Weißabgleich setzen. Wichtig nur: NIEMALS auf die Automatik zu vertrauen. Die ist in LR hart optimiert. Super bei normalen Aufnahmen, weniger gut bei speziellen Anforderungen.

Hier endet der Schmerz aber noch nicht – viele IR-Fotografen wollen irgendwann Farbkanäle tauschen. Lightroom ist in diesem Fall nicht gerade intuitiv, spätestens hier ist also der Wechsel zu einer „großen“ Bildbearbeitung angesagt.

Das nächste Problem: „Intelligente“ Software a la Lightroom produziert oft rauschigere IR-Bilder als notwendig. Warum? Weil weder die Entwicklungsalgorithmen, insbesondere das Demosaicing, noch das berühmte Denoising von Lightroom auf unseren Anwendungsfall passen. Natürlich sieht man das nicht immer sofort, insbesondere nicht wenn man das Bild verkleinert betrachtet statt in 100%. In der Praxis heißt es aber, selbst wenn das Bild auf den ersten Blick rauscharm scheint, dass weit weniger Spielraum bei der Korrektur der Bilder und weniger Details als möglich zur Verfügung steht. Außerdem passiert es gerade bei der Anpassung der Farbkanäle schneller als einem lieb ist, dass Grenzen erreicht und Kanäle geclippt werden …

Woher kommt das? Ganz einfach: Wer einen RAW-Entwickler auf IR-Fotos loslässt, verwirrt die Software geradezu zwangsweise. Anders als bei „normalen“ Bildern ist die Bildinformation nicht gleichmäßig über die vier Filter eines Bayer-Sensors verteilt. Stattdessen ist die Bildinformation im Rot-Kanal überdurchschnittlich hoch und in den Grün- und Blau-Kanälen niedrig und rauschig. Die Aufgabe eines RAW-Entwicklers ist es ja, durch die Wahl eines geeigneten Algorithmus aus diesen Signalwerten die richtigen Farben zu berechnen. Gerade bei High-ISO-Bildern, also im Fall von hohem Rauschen, nimmt die Software andere Algorithmen als bei Low-ISO. Ein Infrarotbild kommt nun oft, besonders wenn es am Tag gemacht wurde, mit einem niedrigen ISO-Wert (100, 200) daher, rauscht aber trotzdem gewaltig in zwei der drei Farbkanäle. Wer also versucht, den optimalen Fall herauszukitzeln, möchte schon an dieser Stelle der Software gezielt vorschreiben, wie die RAW-Entwicklung stattzufinden hat. In vielen Tools geht das leider nur sehr eingeschränkt. Denoising ist ganz ähnlich: Moderne Software kommt mit mehreren speziell trainierten AI-Modellen und wählt diese basierend auf den Bild-Metadaten. Automatisches Denoising in Lightroom oder den von mir so geliebten DxO-Tools ist dadurch ein „Hit and Miss“. Man darf einfach nicht blind vertrauen. In vielen meiner Aufnahmen machen diese Tools das Rauschen sogar schlimmer, wenn ich nicht aufpasse.

Alle diese Probleme lassen sich natürlich gezielt in einer Bildbearbeitung ausgleichen. Profis behelfen sich mit kanal-spezifischen Luminanzmasken und machen das Denoising „klassisch“, also ohne AI-Tools. Das wird nur schnell auch sehr umständlich und zumindest ich verliere manchmal auch den Überblick darüber was ich eigentlich gerade versuche zu tun. Bildbearbeitung mischt sich mit Bildentwicklung und das Ergebnis leidet.

Tja, was nun? Ich mache das ja schon eine Weile und habe für einige dieser Themen inzwischen ganz gute Lösungen gefunden. Spannend in der Rückschau ist für mich die Reise, die ich von „blind einfach ein Tutorial durchklicken und lernen, was man machen muss, um einen Look zu erreichen“ hin zu „immer tiefer in Sensoren, Dateiformate, Basisbearbeitung“ gemacht habe. Gerade in Sachen IR wird auch viel im Internet geschrieben das nur so halb wahr ist oder es werden Erklärungen geliefert die nicht zum Effekt passen. Darum dieser Blogpost, ich habe zwar keinen Anspruch auf Fehlerfreiheit aber vielleicht helfen die Notizen ja irgendwem weiter der/die über die simplen Basics hinaus ist und es jetzt einfach mal sauber machen wollen.

Wichtig ist dabei zu verstehen, dass ich selbst mich nicht als besonders guten Bildbearbeiter sehe. Sobald meine RAWs ordentlich entwickelt sind, bastele ich mehr als geziekt zu editieren. Photoshop & Co gehören bei mir zwar zum Werkzeug aber 80% der Funktionen darin fühlen sich esoterisch und gefährlich an… Aber zumindest den Anfang der Bearbeitungskette glaube ich inzwischen durchdrungen zu haben, hier also mein Workflow, Stand 2025:

Mein Workflow für maximale Qualität (meine Tools der Wahl: RawTherapee & DxO)

Nach viel Herumprobieren habe ich einen Workflow entwickelt, der die Stärken verschiedener Programme kombiniert. Die Grundidee: RawTherapee für die technische Grundlagenarbeit am RAW nutzen und erst danach mein Lieblings-Tool DxO PhotoLab für die optischen Korrekturen und die kreative Optimierung einsetzen. Beide Tools lassen sich natürlich ggf. durch andere Werkzeuge ersetzen. Besonders die Rolle von DxO PhotoLab ist austauschbar. Allerdings halte ich nach jahrelangem Rumprobieren RawTherapee tatsächlich für die mächtigste Option, einfach weil das Tool gerade bei den Basisalgorithmen geradezu beliebig konfigurierbar ist. Dichtauf folgt dann DarkTable. Ich persönlich mag DT nicht besonders, aber man muss dem Tool lassen, dass auch DT viele Eingriffsmöglichkeiten bietet die bei den großen Produktivitätstools oft wegoptimiert oder zusammengefasst wurden. Last not least: Mein IR Workflow ist anders als mein Ablauf für „normale“ Bilder. Bei denen bleibe ich einfach von Anfang bis Ende in DxO und früher war ich dafür überwiegend in LR unterwegs. Aber zurück zum IR Workflow…

Das Ziel ist es, in RawTherapee ein technisch perfektes, aber neutrales 16-Bit TIFF zu erzeugen – ein „digitales Negativ“. Erst dieses wird dann weiterbearbeitet. Warum? Weil es ja gerade darauf ankommt die Sensordaten kontrolliert zu interpretieren und dann diese Interpretation zu fixieren. TIFF sind allerdings schmerzhaft große Dateien, nur so als Wort der Warnung. Dafür sind die aber verlustfrei und bieten maximale Bildinformation zur weiteren Bearbeitung.

Phase 1: Das technische Fundament in RawTherapee

Hier geht es darum, alle Entscheidungen zu treffen, bei denen automatisierte Programme aufgrund der IR-Eigenheiten scheitern würden. Wir überschreiben die falschen Annahmen der Software ganz bewusst.

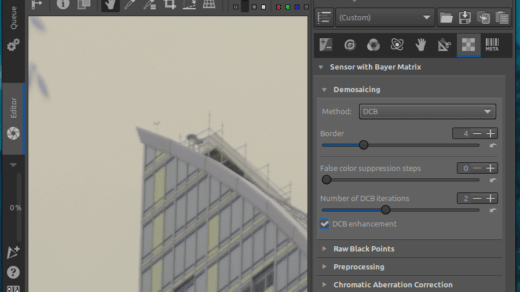

- Demosaicing – Der wichtigste Schritt!

Hier entscheiden wir, wie aus den rohen Sensordaten ein Bild berechnet wird. Bei 100% Zoom lassen sich die Unterschiede am besten erkennen.

- Für 720nm-Filter (klassisch IR): Ich starte hier meist mit

LMMSEoderIGV. Diese Algorithmen sind für hohes Rauschen optimiert und verhindern die typischen „Labyrinth-Artefakte“, die durch das Rauschen in den G- und B-Kanälen entstehen können. Wer ein reines Schwarz-Weiß-Bild anstrebt, kann auchMonowählen – das liefert oft die schärfsten Ergebnisse, da es sich auf den sauberen Rot-Kanal konzentriert. - Für 550nm-Filter („Super Color“): Hier hat sich für mich

DCBals guter Startpunkt erwiesen. Meine EOS RP hat keinen Anti-Aliasing-Filter, undDCBist laut Dokumentation gut darin, Falschfarben bei solchen Sensoren zu vermeiden. - Falschfarben-Unterdrückung: Bei 550nm-Bildern ist dieser Regler Gold wert. Ein Wert von 2 oder 3 beseitigt die typischen pinken/grünen Farbflecken, ohne die Schärfe zu beeinträchtigen. Bei 720nm lasse ich ihn auf 0 oder 1.

- Weißabgleich – Die manuelle Kontrolle

Die Automatik ist hier eigentlich nutzlos, denn Infrarot ist nun mal „unsichtbar“, die Bilder mit denen wir es zu tun haben sind also eine Form der Falschfarbenfotografie und es ist damit die Entscheidung der Fotografierenden welchen Effekt wir anstreben. Trotzdem kann man natürlich auch mal auf die Automatik klicken, je nach Tool kommt vielleicht etwas raus das gefällt. Achtet dabei aber unbedingt darauf nicht aus Versehen einen der Kanäle zu clippen. Genau darum setze ich selbst die WB grundsätzlich selbst.

- Pipetten-Werkzeug: Ein Klick auf gesundes, grünes Laub (das im IR fast weiß reflektiert) oder auf Wolken ist meist mein erster Versuch. Aber wie gesagt: Ihr entscheidet welchen Farbshift ihr wollt.

- Fein-Tuning: Mit den Reglern für

TemperaturundTönungnachjustieren. - Das Power-Tool: Wenn das Bild immer noch einen Farbstich hat, hat RawTherapee ein spezielles Tool, das wir für uns gemacht ist: der

Rot/Blau-Equalizer. Dieser Regler erlaubt die direkte Steuerung des Verhältnisses von Rot zu Blau und kann hartnäckige Farbstiche eliminieren. Warum ist es wie für uns gemacht? Weil in IR ja eben der Rotkanal zu Ungunsten des Blau Kanals überbetont ist. Der Weißabgleich schiebt die Werte zwischen Rot und Blau hin und her, der Equalizer kann dieses Verhältnis justieren.

3. Belichtung & Rauschreduzierung

- Belichtung: Ich passe die Belichtung und den Schwarzwert so an, dass das Histogramm weder links noch rechts clippt. Wichtig: Die Lichterwiederherstellung lasse ich aus, da sie für sichtbares Licht optimiert ist und im IR seltsame Ergebnisse liefern kann. Ich belichte auch bei der Aufnahme mit Histogramm LTTR (Lean To The Right). Das heißt ich belichte gezielt so hell, dass die Lichter gerade so nicht clippen. Der Grund: in IR „saufen“ die Details im Schatten schnell im Rauschen ab. Das einzige Gegenmittel ist mehr Signal einzufangen, also idealerweise länger zu belichten. ISO hochdrehen ist übrigens eine eher schlechte Idee, weil damit auch Rauschen verstärkt wird. Man will also möglichst niedrige ISO bei möglichst viel Signal. Heißt also Blende auf oder Belichtungszeit hoch.

- Rauschreduzierung: Hier konzentriere ich mich ausschließlich auf das Farbrauschen (

Chroma). Das Luminanzrauschen fasse ich nicht an. Ein manueller Eingriff beim Chroma-Regler beseitigt die Farbflecken in den schwachen Kanälen sehr effektiv. - Was man in dieser Phase NICHT tun sollte: Schärfen, Kontraste anpassen, an der Sättigung drehen oder andere kreative Werkzeuge verwenden. Das Ziel ist ein „flaches“, neutrales, aber technisch sauberes Bild.

Phase 2: Der Export als digitales Negativ

Wenn alles passt, wird das Bild für die Weitergabe vorbereitet.

- Dateiformat: TIFF

- Bittiefe: 16-bit (absolut entscheidend für die Qualität!)

- Farbprofil: Ein großer Farbraum wie ProPhoto RGB oder Rec2020. Das stellt sicher, dass keine der einzigartigen IR-Farben beim Export verloren gehen.

Phase 3: Die Kür in DxO PhotoLab (oder einem anderen Tool)

Die exportierte TIFF-Datei ist nun ein „braves“, sauberes Bild. Die problematischen IR-Artefakte sind bereits manuell und korrekt behandelt. Jetzt kann DxO seine ganze Stärke ausspielen, ohne verwirrt zu werden.

- Optische Korrekturen: DxOs erstklassige Korrekturen für Verzeichnung, Vignettierung etc. anwenden.

- Kontrast & Klarheit: Tools wie ClearView Plus und der Mikrokontrast-Regler funktionieren jetzt wunderbar.

- Kreative Bearbeitung: Wer einen Kanaltauch für den „False-Color-Look“ machen möchte, dreht den Regler im HSL Tool um 180 Grad oder übergibt die TIFF-Datei an Photoshop, Affinity oder GIMP. Eurer Kreativität sind keine Grenzen gesetzt.

- Falls doch noch Rauschen übrig ist: Es wird euch direkt auffallen – bei der Arbeit mit TIFF verschwinden all die fast schon magischen AI Denoising Tools, denn die arbeiten meist mit den RAW Daten und brauchen die auch. Aber es gibt Ausnahmen. Zum einen sind natürlich die „klassischen“ Tools immer noch verfügbar, aber auch AI Tools existieren. Topaz Denoise AI z.B. funktioniert problemlos auch mit TIFF Dateien und auch viele der Photoshop Automatiken stehen weiterhin zur Verfügung.

Dieser Workflow mag auf den ersten Blick umständlich wirken, aber er stellt sicher, dass jede Entscheidung von dem Werkzeug getroffen wird, das am besten dafür geeignet ist. Das Ergebnis ist eine sichtbar höhere Bildqualität und mehr Flexibilität für die kreative Gestaltung. Es optimiert auch für den Grenznutzen. Wer pragmatisch sein will: Werft einen Blick auf die Automatiken und achtet auf die Noise Level. Abhängig vom Bildmotiv mag es ja auch egal sein und ein simples Spiel mit den Automatiken reicht aus. Meine abschließende Empfehlung: Wer IR fotografiert sollte sich dringend andere RAW Tools anschauen, selbst wenn das eigene Herz eigentlich an Lightroom hängt. Denn selbst wenn man nicht selbst Algorithmen wählen will dann ist allein schon das Handling von Weißabgleich und IR spezifischen Farbverschiebungen oft besser gelöst. Tools wie RawTherapee und Darktable sind obendrein kostenlos, es tut also zumindest nicht im Geldbeutel weh..

Mehr Lesestoff gefällig?

- Demosaicing Artikel in der RawPedia

- Custom DNG Tutorial for setting a white balance for infrared photography

- Bayer Sensor (Wikipedia Artikel)

- Advanced Infrared Photography Processing: The Power of Luminosity Masks

Wie funktionieren Weißabgleich und Tint Tools?

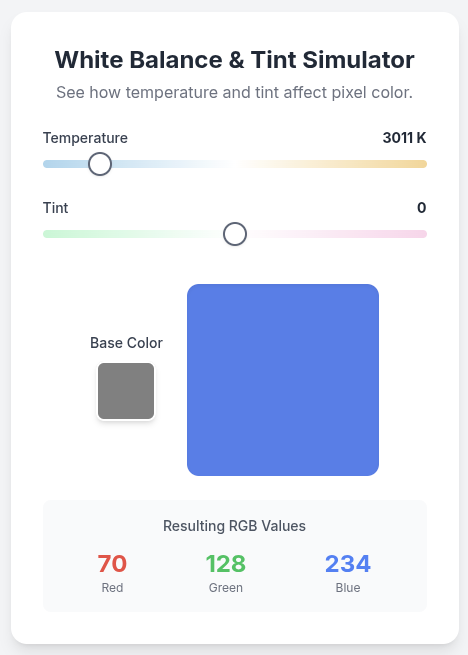

Jeder Pixel besteht aus der Mischung eines Rot, Grün, Blau Wertes. Um den Wert zu berechnen treffen Demosaicing Algorithmen Annahmen was die übliche Verteilung angeht und kombinieren dann die Sensorwerte entsprechend. Der Weißabgleich verschiebt nun die Balance zwischen dem R(ot) und dem B(lau) Wert hin zu kälter (Richtung blau) oder wärmer (Richtung rot). Tint macht dasselbe aber für den Grünwert. Der bleibt beim Weißabgleich nämlich eigentlich unangetastet.

Wer rumspielen will, findet hier einen kleinen Simulator der das für EINEN Pixel simuliert. Einfach die Base Color setzen und an den Reglern rumspielen. Viel Spaß 🙂

Neueste Kommentare